Mange virksomheter ser potensialet i å bruke avanserte språkmodeller som GPTer, og ønsker å integrere denne teknologien i sine egne tjenester. Hva betyr forpliktelsene i AI Act for tilbydere av AI-systemer?

EU har tatt et banebrytende skritt mot en tryggere og mer ansvarlig bruk av kunstig intelligens (AI) med vedtakelsen av AI Act. Dette omfattende regelverket har som mål å sikre at AI-systemer som utvikles, tilbys eller tas i bruk innenfor EU, gjøres på en måte som respekterer grunnleggende rettigheter, helse, sikkerhet og miljø. Det er også EUs mål at regelverket skal bidra til at AI faktisk utvikles og brukes.

Kjernen i AI Act er en risikobasert tilnærming. Dette betyr at jo høyere risiko et AI-system potensielt utgjør for individer eller samfunnet, desto strengere krav stilles til systemet. Regelverket gjelder for alle ledd i AI-verdikjeden, fra utviklere og importører til distributører og sluttbrukere.

I dagens teknologiske landskap er det få aktører som har ressurser og kompetanse til å utvikle egne språkmodeller fra grunnen av. Dette fører til at mange velger å integrere eksisterende modeller, som store språkmodeller (GPTer) fra eksempelvis OpenAI eller Google, i egne AI-løsninger som de ønsker å tilby markedet. Det er viktig å være klar over at både direkte bruk og tilpasning av slike store språkmodeller faller inn under AI Act, og at tilbyderen er ansvarlig for å etterleve forpliktelsene basert på AI-systemets tiltenkte bruksområde og risiko.

Det er derfor nødvendig at tilbydere skaffer seg oversikt over hvilke forpliktelser de påtar seg ved å tilby slike AI-systemer. Vi ønsker i det følgende å gi en oversikt over hvordan tilbydere kan kartlegge sine forpliktelser etter AI Act.

Det første enhver tilbyder av AI-systemer må gjøre er å kartlegge hvilken risikokategori deres system faller inn under. AI Act opererer med et hierarki av risikokategorier, fra forbudte systemer til systemer med høy, begrenset eller minimal risiko. Klassifiseringen avhenger av systemets tiltenkte formål (hva det skal brukes til) og potensielle skadevirkninger.

Uakseptabel risiko: Strengt forbud

AI-systemer som anses å utgjøre en uakseptabel risiko er forbudt. Dette inkluderer systemer som manipulerer menneskelig atferd, foretar sosial skåring, predikerer kriminalitet, brukes i storskala ansiktsgjenkjenning eller emosjonsgjenkjenning. Tilbydere må sikre at sitt AI-systemet ikke faller inn under denne kategorien.

Høy risiko: Omfattende forpliktelser

Høyrisikosystemer er underlagt de strengeste og mest omfattende kravene. Denne kategorien kan deles i to underkategorier:

- Enkelte produkter omfattet av annen produktsikkerhetslovgivning:Dette gjelder produkter der AI-systemer er integrert, der produktet allerede er regulert i sektorspesifikk EU-lovgivning. Dette omfatter blant annet AI-systemer som integreres med produkter som er omfattet av øvrig EU-regelverk, eksempelvis regler for medisinsk utstyr, maritimt utstyr eller leker. Slike systemer kan måtte oppfylle både den relevante sektorspesifikke lovgivningen og relevante bestemmelser i AI Act dersom vilkårene tilsier at produktet er å anse som et høyrisiko AI-system.

- Systemer med spesifikke høyrisikoformål: Dette inkluderer AI-systemer brukt til spesifikke opplistede formål i AI Act, blant annet rekruttering, utdanning, kritisk infrastruktur, grunnleggende private og offentlige tjenester, rettshåndhevelse, migrasjon, etc.

Hvilke krav må tilbydere av høyrisiko AI-systemer forholde seg til?

Tilbydere av høyrisikosystemer må implementere omfattende risikostyring, datahåndtering, teknisk dokumentasjon, loggføring, krav til at data brukt for å trene modellen er av høy kvalitet, menneskelig tilsyn og sikre systemets pålitelighet, robusthet og informasjonssikkerhet. I tillegg må de overholde krav til CE-merking, samsvarsvurderinger og dokumentasjon som vi kjenner fra annen produktsikkerhetslovgivning.

For å illustrere hvordan et AI-system kan omfattes av høyrisiko-kategorien i AI Act har vi trukket frem tre ulike praktiske eksempler:

- Scenario 1: En tilbyder som utvikler et AI-system med formål om å stille medisinske diagnoser vil omfattes av høyrisiko-kategorien ettersom medisinsk utstyr er regulert av et sektorspesifikt regelverk som er omfattet av listen i punkt 1 over og det medisinske utstyret som brukes til å stille diagnoser er klassifisert i en klasse som krever samsvarsvurderinger utført av tredjepart.

AI Act og forholdet til sektorspesifikk lovgivning: AI Act supplerer eksisterende sektorspesifikke regelverk for produktsikkerhet. Regelverket overlapper med krav til sertifisering og CE-merking, men AI-Act adresserer også spesifikt AI-relaterte risikoer som ikke dekkes av tidligere lovgivning. Dette sikrer at produkter med integrerte AI-systemer er både sikre og etisk forsvarlige. For produkter der sektorspesifikk lovgivning stiller krav til samsvarsvurderinger utført av tredjeparter, kan integrerte AI-systemer vurderes som en del av allerede etablerte prosesser for samsvarsvurderinger.

- Scenario 2: En virksomhet tilbyr et AI-system som skal beregne kredittverdighet eller gi kredittscore på privatpersoner i bank eller forsikringssammenheng. Et slikt AI-system vil omfattes av kategorien høy risiko ettersom AI-systemer som vurderer privatpersoners adgang til grunnleggende tjenester er omfattet av AI Acts spesifikke høyrisikoformål som nevnt i punkt 2 over.

- Scenario 3: En tilbyder integrerer en ChatGPT, som i utgangspunktet ikke er klassifisert som høy risiko. Tilbyderen gjør deretter små endringer i brukertilpasning og markedsfører verktøyet som et AI-rekrutteringsverktøy. En generell språkmodell som i utgangspunktet omfattes av kategorien begrenset risiko, vil nå regnes som et høyrisiko AI-system fordi systemets tiltenkte formål nå vil omfattes av høyrisikokategoriene nevnt over i punkt 2.

I slike tilfeller må leverandøren av GPT samarbeide med tilbyderen av høy-risiko AI-system for å tilfredsstille kravene til tekniske dokumentasjon.

Begrenset risiko: få forpliktelser

AI-systemer med begrenset risiko er underlagt få krav etter AI Act. Systemer med begrenset risiko inkluderer General Purpose AI-systemer (som ikke er ment for eller markedsført som et verktøy til høyrisiko-bruk) som er ment å samhandle direkte med mennesker, generere eller redigere innhold.

Tilbydere av AI-systemer med begrenset risiko må sørge for at brukerne informeres om at de samhandler med et AI-system eller at dataene som genereres er produsert av AI, med mindre dette fremstår åpenbart for brukeren. Tilbydere må også ha oversikt over blant annet teknisk dokumentasjon for språkmodellen og dens treningsgrunnlag.

Minimal risiko: noen forpliktelser

AI-systemer med minimal risiko er ikke direkte definert i AI Act, men omfatter alle AI-systemer som ikke faller inn under kategoriene uakseptabel, høy eller begrenset risiko. Dette innebærer blant annet AI-systemer for spamfiltre, anbefalingsalgoritmer for musikk eller filmer, AI-drevne videospill og enkle chatbots for kundeservice.

Tilbyderne av disse systemene må respektere og beskytte immaterielle rettigheter og konfidensiell forretningsinformasjon og overholde annen relevant lovgivning, som for eksempel personvernlovgivningen.

Dersom et AI-system kategorisert som minimal risiko baserer seg på en General Purpose AI modell, stiller AI-Act krav til teknisk dokumentasjon og dokumentasjon om modellen og dens treningsgrunnlag etc. Det gjelder også noen øvrige krav til generelle språkmodeller med et generelt formål, såkalte General Purpose AI system.

AI Act er et viktig skritt mot ansvarlig bruk av AI i Europa

Den risikobaserte tilnærmingen balanserer behovet for innovasjon med beskyttelse av enkeltpersoner og samfunnet.

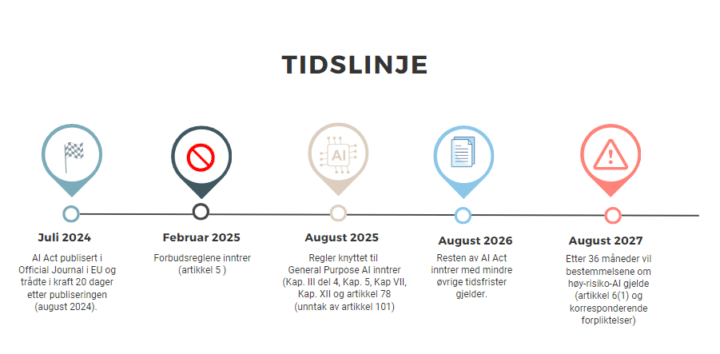

For tilbydere er det avgjørende å forstå og implementere kravene AI Act stiller. Slik tidslinjen under viser har virksomheter fortsatt tid på seg til å kartlegge og forberede seg på kravene som stilles. AI Act oppfordrer også aktørene om en bevisstgjøring omkring etiske retningslinjer for bruk av AI, der Ethical guidelines for trusthworthy AI kan gi god innsikt.

Ved å ta en proaktiv tilnærming kan tilbydere sikre at de oppfyller forpliktelsene i AI Act og kan ta en ledende rolle i bruken av AI-verktøy. Det er også viktig å huske på at du alltid må vurdere om bruken av AI-systemer berører øvrige rettsregler. Som vi har vært inne på tidligere, har vi allerede eksisterende teknologinøytrale lover, inkludert GDPR, og som treffer bruken av kunstig intelligens avhengig av bruksområde.

Ta kontakt med oss i Føyen dersom du har spørsmål om AI Act og bruk av kunstig intelligens i din virksomhet.

Artikkelen er skrevet av Magnus Rosenberg, Camilla Gjersem og Vebjørn Søndersrød.